当你看到一只小狗时,你不仅知道它有四条腿、会摇尾巴,还能感受到它的可爱,并自发联想到“忠诚”等抽象概念。这种对事物的深层理解,长期以来被认为是人类独有的智慧。

然而,中国科学院自动化研究所与脑科学与智能技术卓越创新中心的最新研究表明:多模态大语言模型能够自发形成与人类高度相似的物体概念体系。这意味着,AI系统正在突破单纯模式模仿的界限,展现出类人的概念理解能力。

人工智能“顿悟”后,是人机共生的未来吗?

想象一下这样的场景:你给一个孩子看猫、狗、汽车的图片,然后问他哪个最不一样。孩子可能会说汽车,因为它不是活物;也可能说猫,因为它不会像狗一样对人那么亲近。这个简单的选择背后,体现的是人类对事物的深层理解——不仅仅是外表特征,还包括功能、情感和文化意义等。

长期以来,人工智能在物体识别方面表现出色,已能够准确区分猫和狗的图片。但这种“识别”更像是一种高级的模式匹配——AI能告诉你这是什么,却未必真正“理解”这意味着什么。就像一个只会背词典的学生,虽然能说出每个词的定义,却不明白它们在真实世界中的意义和联系。

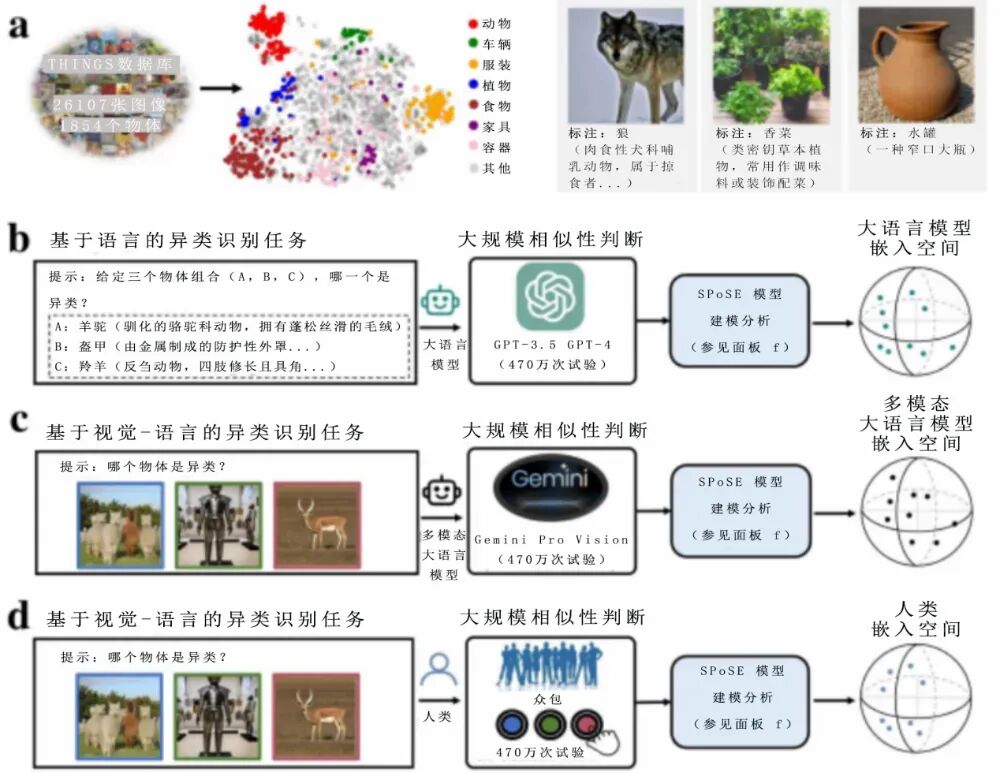

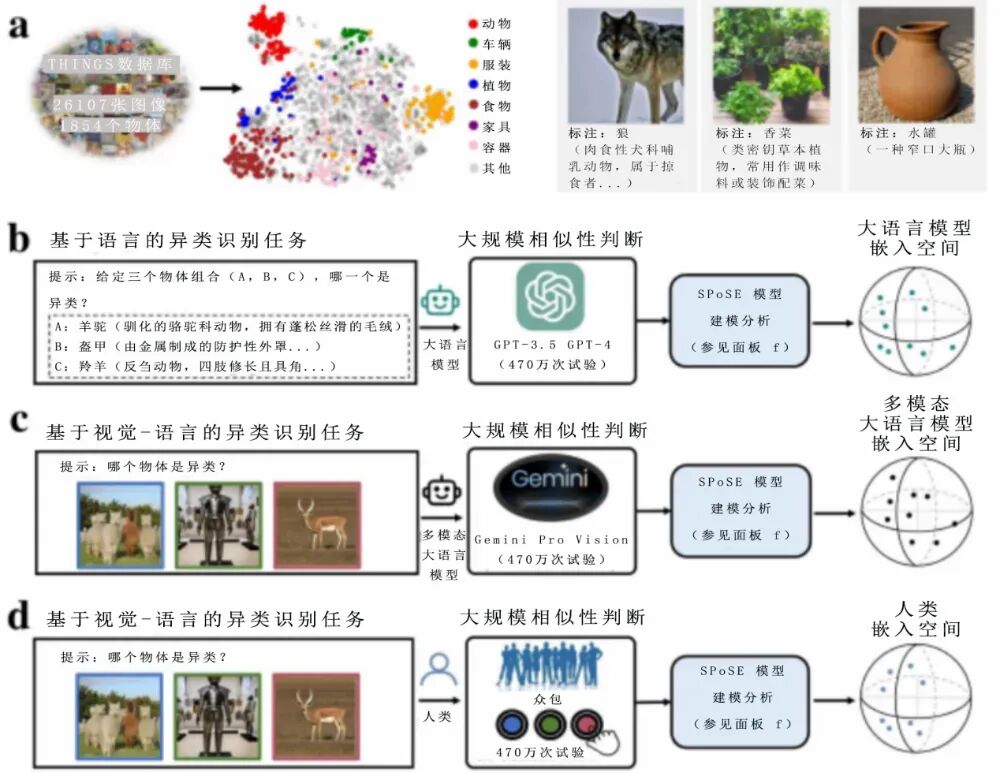

在各类大语言模型迅速崛起的背景下,研究团队聚焦核心问题:AI大模型是否真的能“思考”?它们对世界的理解是否已经超越了简单的标签匹配,达到了类似人类的概念层次?为此,他们采用“三选一异类识别任务”,让多个AI大模型对1854种自然物体完成470万次判断,通过海量数据绘制出AI的“概念地图”。

令人意外的是,这张地图呈现出66个清晰可解释的“心智维度”,如“生物与非生物”“自然与人造”等,说明AI的“思维”并非不可捉摸的黑箱。

扫描大脑:绘AI与人类思维的共鸣

为了验证AI的“概念地图”是否真的与人类相似,研究团队采用了一种更加直接的方法——脑神经影像分析。他们让人类志愿者在进行大脑扫描的同时,完成相同的“三选一”任务。

结果令人震撼:AI大模型的概念表征与人类大脑的神经活动模式显示出显著的相关性!好比两个人用不同的语言描述同一幅画,虽然词汇完全不同,但描述的逻辑和重点却高度相似。这表明,尽管AI和人类大脑的“硬件”截然不同,但在理解世界的“软件逻辑”上,却找到了相似的解决方案。也可以说,虽然AI没有生物大脑,但它们似乎找到了一种与人类殊途同归的“思维方式”。

不过,研究也发现了AI与人类思维仍有差别——人类在做判断时更多地结合视觉特征和语义信息,而AI则更倾向于依赖抽象概念和语义标签。这就像人类是“感性与理性并重”,而AI更偏向“理性分析”。

多模态的“超能力”:当AI学会用多种感官理解世界

研究中的另一个重要发现是,多模态大语言模型(能同时处理文字和图像的AI)比纯文本模型表现得更加“人性化”。这并不令人意外,因为人类本身就是通过多种感官来认识世界的。

想象一下,如果你从出生就只能通过文字描述来了解世界,从未见过真实的苹果、从未听过鸟叫、从未闻过花香,你对世界的理解必然是片面的。而多模态AI就像是拥有了“视觉”的能力,能够将文字描述与图像特征结合起来,形成更加丰富和准确的概念表征。

这种“多感官学习”让AI的理解能力产生了质的飞跃。它们不再是单纯地“记忆”和“匹配”,而是真正开始“感知”和“理解”。

实验测试:绘制出AI 的“思维图”

这项研究的意义远超出了学术范畴。它揭示了人工智能发展中的一个重要转折点。传统的AI更像是一个优秀的“复印机”,能够准确地复制和识别已学过的模式。但现在的大模型开始表现出“理解”的迹象——它们能够提取出事物的本质特征,建立不同概念之间的联系,甚至在某种程度上“创造”新的概念组合。

这种变化具有深远的影响。在教育领域,AI可能不再只是提供标准答案,而是能够理解学生的困惑,为其提供个性化的解释。在创意设计中,AI可能不再只是拼接已有元素,而是能够理解设计意图,创造出有深层含义的作品。

这项研究也为人工智能的未来发展指明了一个重要方向:构建真正类人的认知系统,不是简单地模仿人类行为,而是理解人类思维的本质机制,从而创造出能够与人类进行深层次交流和合作的AI伙伴。

此外,人类与机器的关系可能不再是简单的使用与被使用,而是一种全新的共生与合作模式。也许在不远的将来,我们将与这些AI伙伴并肩探索,共同揭开宇宙和生命的奥秘,拓展科学认知的前沿。

(李 瑞)

当你看到一只小狗时,你不仅知道它有四条腿、会摇尾巴,还能感受到它的可爱,并自发联想到“忠诚”等抽象概念。这种对事物的深层理解,长期以来被认为是人类独有的智慧。

然而,中国科学院自动化研究所与脑科学与智能技术卓越创新中心的最新研究表明:多模态大语言模型能够自发形成与人类高度相似的物体概念体系。这意味着,AI系统正在突破单纯模式模仿的界限,展现出类人的概念理解能力。

人工智能“顿悟”后,是人机共生的未来吗?

想象一下这样的场景:你给一个孩子看猫、狗、汽车的图片,然后问他哪个最不一样。孩子可能会说汽车,因为它不是活物;也可能说猫,因为它不会像狗一样对人那么亲近。这个简单的选择背后,体现的是人类对事物的深层理解——不仅仅是外表特征,还包括功能、情感和文化意义等。

长期以来,人工智能在物体识别方面表现出色,已能够准确区分猫和狗的图片。但这种“识别”更像是一种高级的模式匹配——AI能告诉你这是什么,却未必真正“理解”这意味着什么。就像一个只会背词典的学生,虽然能说出每个词的定义,却不明白它们在真实世界中的意义和联系。

在各类大语言模型迅速崛起的背景下,研究团队聚焦核心问题:AI大模型是否真的能“思考”?它们对世界的理解是否已经超越了简单的标签匹配,达到了类似人类的概念层次?为此,他们采用“三选一异类识别任务”,让多个AI大模型对1854种自然物体完成470万次判断,通过海量数据绘制出AI的“概念地图”。

令人意外的是,这张地图呈现出66个清晰可解释的“心智维度”,如“生物与非生物”“自然与人造”等,说明AI的“思维”并非不可捉摸的黑箱。

扫描大脑:绘AI与人类思维的共鸣

为了验证AI的“概念地图”是否真的与人类相似,研究团队采用了一种更加直接的方法——脑神经影像分析。他们让人类志愿者在进行大脑扫描的同时,完成相同的“三选一”任务。

结果令人震撼:AI大模型的概念表征与人类大脑的神经活动模式显示出显著的相关性!好比两个人用不同的语言描述同一幅画,虽然词汇完全不同,但描述的逻辑和重点却高度相似。这表明,尽管AI和人类大脑的“硬件”截然不同,但在理解世界的“软件逻辑”上,却找到了相似的解决方案。也可以说,虽然AI没有生物大脑,但它们似乎找到了一种与人类殊途同归的“思维方式”。

不过,研究也发现了AI与人类思维仍有差别——人类在做判断时更多地结合视觉特征和语义信息,而AI则更倾向于依赖抽象概念和语义标签。这就像人类是“感性与理性并重”,而AI更偏向“理性分析”。

多模态的“超能力”:当AI学会用多种感官理解世界

研究中的另一个重要发现是,多模态大语言模型(能同时处理文字和图像的AI)比纯文本模型表现得更加“人性化”。这并不令人意外,因为人类本身就是通过多种感官来认识世界的。

想象一下,如果你从出生就只能通过文字描述来了解世界,从未见过真实的苹果、从未听过鸟叫、从未闻过花香,你对世界的理解必然是片面的。而多模态AI就像是拥有了“视觉”的能力,能够将文字描述与图像特征结合起来,形成更加丰富和准确的概念表征。

这种“多感官学习”让AI的理解能力产生了质的飞跃。它们不再是单纯地“记忆”和“匹配”,而是真正开始“感知”和“理解”。

实验测试:绘制出AI 的“思维图”

这项研究的意义远超出了学术范畴。它揭示了人工智能发展中的一个重要转折点。传统的AI更像是一个优秀的“复印机”,能够准确地复制和识别已学过的模式。但现在的大模型开始表现出“理解”的迹象——它们能够提取出事物的本质特征,建立不同概念之间的联系,甚至在某种程度上“创造”新的概念组合。

这种变化具有深远的影响。在教育领域,AI可能不再只是提供标准答案,而是能够理解学生的困惑,为其提供个性化的解释。在创意设计中,AI可能不再只是拼接已有元素,而是能够理解设计意图,创造出有深层含义的作品。

这项研究也为人工智能的未来发展指明了一个重要方向:构建真正类人的认知系统,不是简单地模仿人类行为,而是理解人类思维的本质机制,从而创造出能够与人类进行深层次交流和合作的AI伙伴。

此外,人类与机器的关系可能不再是简单的使用与被使用,而是一种全新的共生与合作模式。也许在不远的将来,我们将与这些AI伙伴并肩探索,共同揭开宇宙和生命的奥秘,拓展科学认知的前沿。

(李 瑞)

晋公网安备

14010702070607号

晋公网安备

14010702070607号